提及人工智能AI干系的算力芯片,现在绝大多数人的第一反应都是英伟达NVIDIA的GPU,作为AI模型搭建的根本,英伟达的A100/H100险些成为了一块块“金砖”,深受业界喜好。

然而,一方面,外部牵制在上月又一次收紧,海内子工智能行业很难再获取高端算力的支持;另一方面,以GPU为首的传统数字逻辑电路芯片在处理繁芜的人工智能算法时,也存在速率有限、功耗较大的困境。

面对这一寻衅,清华大学自动化系戴琼海院士、吴嘉敏助理教授与电子工程系方璐副教授、乔飞副研究员联合攻关,提出了一种全新的打算架构——“全仿照光电智能打算芯片”(ACCEL)。

这颗芯片的理论算力性能可以达到目前高性能商用芯片的3000余倍,成果揭橥在了《自然》杂志上。

用光打算,更迅速今年10月的2023诺贝尔物理学奖,颁给了“阿秒激光技能”,光速作为人类已知的宇宙中最快速率拥有着很多独特的特性,在物理学中有很多运用。

“如何用光做打算”是业界、学界的主要课题之一。

根据清华大学揭橥的项目论文所述,“全仿照光电打算芯片”(all-analog chip combining electronic and light computing,ACCEL)紧张是针对人工智能领域打算机视觉干系任务的芯片。

传统的打算机视觉处理方案,是外界光芒投射到如相机CMOS这样的芯片上,经由光电转换后输出的数字电旗子暗记,再加以处理。

而ACCEL的处理办法完备不同,其输入的图像并非是一个以数字形式存在的“图片”,而是物理意义上的“光”,相称于给打算机加了一双人眼,而非摄像头。

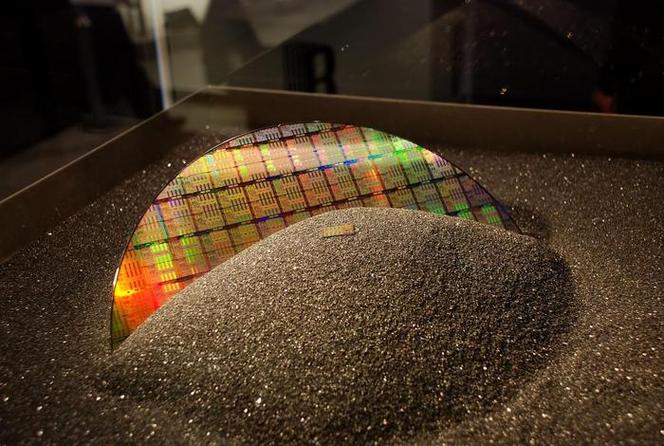

(图源:清华大学)

输入的图像从光学打算部分(optical analog computing,OAC)进入,经由数据压缩处理之后,投射到光电二极管阵列上(论文中称为电子仿照打算electronic analog computing,EAC),EAC通过OAC反馈的信息产生相应的输出,表现为“有或无”的“1或0”,从而实现从仿照旗子暗记到数字旗子暗记的转变,达成结果。

从技能层面看,光芒在OAC部分仅仅是照射通过了一块类似光刻机掩膜版的组件,就完成了旗子暗记压缩和处理,省略了光旗子暗记到电旗子暗记的转换,理论上没有功耗,而且处理速率为光速。加上后续EAC的旗子暗记转换输出一共须要约4.4nJ能量和2ns韶光,即可实现一次打算。

由于光子的高速特性,在处理信息时具有极高的速率和效率,同时功耗很低。根据论文供应的实验数据,在相同打算精度下以串行办法处理图像时,ACCEL在实验中实现了每帧72纳秒的打算延迟和每帧4.38纳焦耳的能耗,远小于英伟达A100 GPU的每帧0.26毫秒延迟和每帧18.5毫焦能耗数据。

(图源:《自然》)

ACCEL的等效算力4600TOP/s,能效比74800TOP/s/W,是英伟达A100 GPU的3000倍以上。

摩尔定律已致极限传统的集成电路技能进步在近些年开始逐步陷入瓶颈。影响了半导体行业半个多世纪的“摩尔定律”已经逐渐放缓,乃至有些失落效的预兆。从近两年消费电子领域的困境可以窥见一二。

(图源:Freeimages)

近几年,手机、PC类处理器的性能提升速率已经放缓,现今最为前辈的3nm工艺产量与良率都面临困境,即便是已经发布的产品,性能提升也比较有限,并且,随着晶体管尺寸几次再三逼近物理极限,密度大增的芯片带来了功耗与发热的双重磨练。

用光替代电作为信息传输的新载体,是个中一条探索道路。

清华大学这次发布的这颗ACCEL只是一颗32×32阵列的小型芯片,工艺上用的是可以称之为“掉队”的180nm工艺,更多是为了观点验证。如果换用相对成熟的28nm,乃至是7nm这样的前辈工艺,都有望实现更高的处理速率,以及更大的神经网络以支持更繁芜的任务。

另一方面,传统的集成电路芯片处理AI这样的繁芜任务时,除了须要芯片本身的算力以外,还须要合营存储器来实现数据存取,比如现在的GPU一样平常都会搭配高带宽的HBM内存,这会造成能量的极大花费。

清华大学电子工程系副教授方璐表示:除算力上风外,在智能视觉目标识别任务和无人系统(如自动驾驶)场景打算中,ACCEL的系统级能效(单位能量可进行的运算数)经实测是现有高性能芯片的400万余倍,这一超低功耗的上风将有助于改进限定芯片集成的芯片发热问题,有望为未来芯片设计带来打破。

有什么用?恰如前文所说,ACCEL紧张是针对人工智能领域打算机视觉干系任务的芯片,运用处景也是集中在如图像识别、高通量筛选、自动驾驶等。尤其在自动驾驶这种须要低延迟和低功耗的运用中可能会有精良的表现。

在终端上,紧张运用可能会是超低功耗的生物识别等等。

必须解释的是,ACCEL对目前发展火热的“大模型”演习险些没有帮助,无法取代通用AI算力芯片。

但伴随着AI芯片竞争日趋激烈,如Intel、AMD、微软、谷歌等厂商都在积极布局,清华大学的研究者们也在努力将光电芯片向着通用打算运用的方向发展,算是为国产AI算力芯片的设计供应了一个新思路。

本文作者:Visssom,不雅观点仅代表个人,题图源:清华大学