01.序言

目前,智能驾驶领域在处理深度学习AI算法方面,紧张采取GPU、FPGA 等适宜并行打算的通用芯片来实现加速。同时有部分芯片企业开始设计专门用于AI算法的ASIC专用芯片,比如谷歌TPU、地平线BPU等。在智能驾驶家当运用没有大规模兴起和批量投放之前,利用GPU、FPGA等已有的通用芯片可以避免专门研发定制芯片(ASIC)的高投入和高风险,但是,由于这类通用芯片设计初衷并非专门针对深度学习,因而存在性能不敷、功耗过高档方面的问题。这些问题随着自动驾驶行业运用规模的扩大将会日益突出。

本文从芯片种类、性能、运用和供应商等多角度先容AI芯片,用于给行业内入门新人扫盲。

02.什么是人工智能(AI)芯片?

从广义上讲,能运行AI算法的芯片都叫AI芯片。

目前通用的CPU、GPU、FPGA等都能实行AI算法,只是实行效率差异较大。但狭义上讲一样平常将AI芯片定义为“专门针对AI算法做了分外加速设计的芯片”。

目前AI芯片的紧张用于语音识别、自然措辞处理、图像处理等大量利用AI算法的领域,通过芯片加速提高算法效率。AI芯片的紧张任务是矩阵或向量的乘法、加法,然后合营一些除法、指数等算法。AI算法在图像识别等领域,常用的是CNN卷积网络,一个成熟的AI算法,便是大量的卷积、残差网络、全连接等类型的打算,实质是乘法和加法。

对汽车行业而言,AI芯片的紧张用于便是处理智能驾驶中环境感知、传感器领悟和路径方案等算法带来的大量并行打算需求。

AI芯片可以理解为一个快速打算乘法和加法的打算器,而CPU要处理和运行非常繁芜的指令集,难度比AI芯片大很多。GPU虽然为图形处理而设计,但是CPU与GPU并不是专用AI芯片,其内部有大量其他逻辑来实现其他功能,这些逻辑对付目前的AI算法来说完备无用。目前经由专门针对AI算法做过开拓的GPU运用较多,也有部分企业用FPGA做开拓,但是行业内对付AI算法一定涌现专用AI芯片。

03.为什么要用AI芯片?

人工智能从功能上来看包括推理和演习两个环节,智能驾驶行业亦然。在演习环节,通过大数据演习出一个繁芜的神经网络模型,目前大部分企业在演习环节紧张利用英伟达的GPU集群完成。推理环节是指利用演习好的模型,利用大量数据推理出各种结论。因此,演习环节对芯片的算力性能哀求比较高,推理环节对大略指定的重复打算和低延迟的哀求很高。

从运用处景来看,人工智能芯片运用于云端和设备端,在智能驾驶领域同样具备云做事器和车载的各种打算平台或域掌握器,在智能驾驶深度学习的演习阶段须要极大的数据量和大量运算,单一处理器无法独立完成,因此演习环节只能在云做事器实现。相对的在设备端即车上,各种ECU、DCU等终端数量弘大,而且需求差异较大。因此,推理环节无法在云端完成,这就哀求车上的各种电子单元、硬件打算平台或域掌握器有独立的推理打算能力,因此必须要有专用的AI芯片来应对这些推理打算需求。

传统的CPU、GPU都可以拿来实行AI算法,但是速率慢,性能低,尤其是CPU,在智能驾驶领域无法实际投入商用。

比如,自动驾驶须要识别道路、行人、红绿灯等路况和交通状况,这在自动驾驶算法里面都是属于并行打算,如果是CPU去实行打算,那么估计车撞到人了也没算出来个结果,CPU并行打算速率慢属于先天不敷。如果用GPU速率要快得多,毕竟GPU专为图像处理并行打算设计,但是GPU功耗过大,汽车的电池无法永劫光支撑正常利用,而且GPU价格相对较高,用于自动驾驶量产的话普通消费者也用不起。其余,GPU由于不是专门针对AI算法开拓的ASIC,实行AI打算的速率上风还没到极限,还有提升空间。

在智能驾驶这样的领域,环境感知、物体识别等深度学习运用哀求打算相应方面必须快!

韶光便是生命,慢一步就有可能造成无法挽回的情形,但是担保性能快效率高的同时,功耗不能过高,不能对智能汽车的续航里程造成较大影响,也便是AI芯片必须功耗低,以是GPU不是适宜智能驾驶的最佳AI芯片选择。因此开拓ASIC就成了一定。

04.AI芯片的种类

当前主流的AI芯片紧张分为三类,GPU、FPGA、ASIC。GPU、FPGA均是前期较为成熟的芯片架构,属于通用型芯片。ASIC属于为AI特定场景定制的芯片。行业内已经确认CPU不适用于AI打算,但是在AI运用领域也是必不可少,其余一种说法是还有一种类脑芯片,算是ASIC的一种。

FPGA(Field Programmable Gate Array,现场可编程门阵列)具有足够的打算能力和足够的灵巧性。FPGA的打算速率快是源于它实质上是无指令、无需共享内存的体系构造。对付保存状态的需求,FPGA中的寄存器和片上内存(BRAM)是属于各自的掌握逻辑的,无需不必要的仲裁和缓存,因此FPGA在运算速率足够快,优于GPU。同时FPGA也是一种半定制的硬件,通过编程可定义个中的单元配置和链接架构进行打算,因此具有较强的灵巧性。相对付GPU,FPGA能管理能运算,但是相对开拓周期长,繁芜算法开拓难度大。

ASIC(Application Specific Integrated Circuit特定用场集成电路)根据产品的需求进行特定设计和制造的集成电路,能够在特定功能上进行强化,具有更高的处理速率和更低的能耗。缺陷是研发本钱高,前期研发投入周期长,且由于是定制化,可复制性一样平常,因此只有用量足够大时才能够分摊前期投入,降落本钱。

4.1 CPU (CentralProcessing Unit)

中心处理器作为打算机系统的运算和掌握核心,是信息处理、程序运行的终极实行单元,CPU 是对打算机的所有硬件资源(如存储器、输入输出单元) 进行掌握调配、实行通用运算的核心硬件单元。

优点:CPU有大量的缓存和繁芜的逻辑掌握单元,非常善于逻辑掌握、串行的运算

缺陷:不善于繁芜算法运算和处理并行重复的操作。

对付AI芯片来说,算力最弱的是cpu。虽然cpu主频最高,但是单颗也就8核,16核的样子,一个核3.5g,16核也就56g,再考虑指令周期,每秒最多也就30g次乘法。还是定点的。

生产厂商:intel、AMD

4.2 GPU (GraphicsProcessing Unit)

图形处理器,又称显示核心、视觉处理器、显示芯片,是一种专门在个人电脑、事情站、游戏机和一些移动设备(如平板电脑、智好手机等)上做图像和图形干系运算事情的微处理器。

优点:供应了多核并行打算的根本构造,且核心数非常多,可以支撑大量数据的并行打算,拥有更高的浮点运算能力。

缺陷:管理掌握能力(最弱),功耗(最高)。

生产厂商:AMD、NVIDIA

4.3 FPGA(Field Programmable Gate Array)FPGA是在PAL、GAL等可编程器件的根本上进一步发展的产物。它是作为专用集成电路(ASIC)领域中的一种半定制电路而涌现的,既办理了定制电路的不敷,又战胜了原有可编程器件门电路数有限的缺陷。

优点:可以无限次编程,延时性比较低,同时拥有流水线并行和数据并行(GPU只有数据并行)、实时性最强、灵巧性最高。

缺陷:开拓难度大、只适宜定点运算、价格比较昂贵

生产厂商:Altera(Intel收购)、Xilinx

4.4 ASIC(Application Specific IntegratedCircuit)ASIC,即专用集成电路,指应特定用户哀求和特定电子系统的须要而设计、制造的集成电路。目前用CPLD(繁芜可编程逻辑器件)和 FPGA(现场可编程逻辑阵列)来进行ASIC设计是最为盛行的办法之一。

优点:它作为集成电路技能与特定用户的整机或系统技能紧密结合的产物,与通用集成电路比较具有体积更小、重量更轻、 功耗更低、可靠性提高、性能提高、保密性增强、本钱降落等优点。

缺陷:灵巧性不足,本钱比FPGA贵

紧张性能指标:功耗、速率、本钱

生产厂商:谷歌、地平线、寒武纪等

4.5 四种芯片的特性总结CPU是一个有多种功能的精良领导者。它的优点在于调度、管理、折衷能力强,打算能力则位于其次。而GPU相称于一个接管CPU调度的“拥有大量打算能力”的员工。

GPU 作为图像处理器,设计初衷是为了应对图像处理中须要大规模并行打算。

因此,其在运用于深度学习算法时,有三个方面的局限性:

第一,运用过程中无法充分发挥并行打算上风。深度学习包含演习和运用两个打算环节,GPU 在深度学习算法演习上非常高效,但在运用时一次性只能对付一张输入图像进行处理,并行度的上风不能完备发挥。

第二,硬件构造固定不具备可编程性。深度学习算法还未完备稳定,若深度学习算法发生大的变革,GPU 无法像FPGA 一样可以灵巧的配置硬件构造。

第三,运行深度学习算法能效远低于FPGA。学术界和家当界研究已经证明,运行深度学习算法中实现同样的性能,GPU 所需功耗远大于FPGA,例如海内初创企业深鉴科技基于FPGA 平台的人工智能芯片在同样开拓周期内相对GPU 能效有一个数量级的提升。

FPGA,其设计初衷是为了实现半定制芯片的功能,即硬件构造可根据须要实时配置灵巧改变。

研究报告显示,目前的FPGA市场由Xilinx 和Altera 主导,两者共同霸占85%的市场份额,个中Altera 在2015 年被intel以167 亿美元收购, Xilinx则选择与IBM进行深度互助,背后都表示了 FPGA 在人工智能时期的主要地位。

只管 FPGA 倍受看好,乃至百度大脑、地平线AI芯片也是基于FPGA 平台研发,但其毕竟不是专门为了适用深度学习算法而研发,实际仍旧存在不少局限:

第一,基本单元的打算能力有限。为了实现可重构特性,FPGA 内部有大量极细粒度的基本单元,但是每个单元的打算能力(紧张依赖LUT 查找表)都远远低于CPU 和GPU中的ALU模块。

第二,速率和功耗相对专用定制芯片(ASIC)仍旧存在不小差距。

第三,FPGA 价格较为昂贵,在规模放量的情形下单块FPGA 的本钱要远高于专用定制芯片。

人工智能定制芯片是大趋势,从发展趋势上看,人工智能定制芯片将是打算芯片发展的大方向。

05.AI芯片算力比拟

5.1 通用芯片—GPUGPU(Graphics Processing Unit)即为图形处理器。NVIDIA公司在1999年发布GeForce256图形处理芯片时首先提出GPU的观点。从此NVIDIA显卡的芯就用这个新名字GPU来称呼。GPU使显卡减少了对CPU的依赖,部分替代原来CPU的事情,特殊是在3D图形处理方面。由于在浮点运算、并行打算等方面,GPU可以供应数十倍乃至于上百倍于CPU的性能。

GPU比较CPU更适宜人工智能打算。GPU和CPU分别针对的是两种不同的运用处景,他们的设计目标不同,CPU须要很强的通用性来处理各种不同的数据类型,同时逻辑判断又会引入大量的分支跳转和中断的处理。这些都使得CPU的内部构造非常繁芜。而GPU善于的则是在不须要被打断的纯净的打算环境中进行类型高度统一的、相互无依赖的大规模数据处理,人工智能的打算适值紧张是后者,这使得原来为图像处理而生的GPU在人工智能时期抖擞第二春。

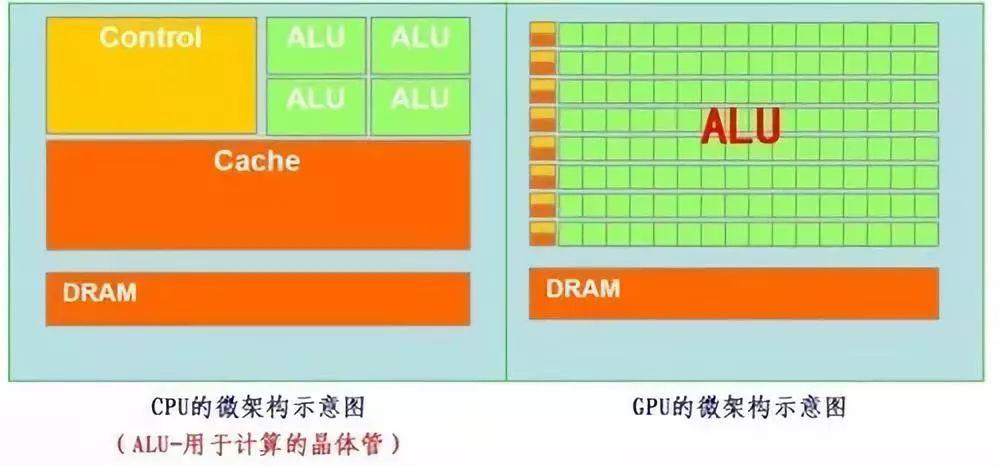

CPU的逻辑运算单元(ALU)较少,掌握器(control)占比较大;GPU的逻辑运算单元(ALU)小而多,掌握器功能大略,缓存(cache)也较少。架构的不同使得CPU善于进行逻辑掌握、串行打算,而GPU善于高强度的并行打算。GPU单个运算单元处理能力弱于CPU的ALU,但是数量浩瀚的运算单元可以同时事情,当面对高强度并行打算时,其性能要优于CPU。现如今GPU除了图像处理外,也越来越多的利用到别的打算中。

CPU根据功能划分,将须要大量并行打算的任务分配给GPU。GPU从CPU得到指令后,把大规模、无构造化的数据分解成许多独立部分,分配给各个流处理集群(SMM)。每个流处理集群再次把数据分解,分配给调度器,调度器将任务放入自身所掌握的打算核心core中完成终极的数据处理任务。

GPU性能较强但功耗较高。以NVIDIA开拓的GPU为例,Xavier最高算力为30Tops,功耗为30W,NVIDIA最新发布的GPUA100比较Volta架构的640个Tensor Core,A100核心的TensorCore减少到了432个,但是性能大幅增强,支持全新的TF32运算,浮点性能156TFLOPS,同时INT8浮点性能624TOPS,FP16性能312TFLOPS,同时功耗也达到了400W。

5.2 半定制化芯片—FPGA

FPGA(Field-ProgrammableGate Array),即现场可编程门阵列。它是在PAL、GAL、CPLD等可编程器件的根本上进一步发展的产物。它是作为专用集成电路(ASIC)领域中的一种半定制电路而涌现的,既办理了定制电路的不敷,又战胜了原有可编程器件门电路数有限的缺陷。

FPGA内部有很多可配置逻辑模块(CLB),这些模块是现实逻辑功能的基本单元,FPGA可通过灵巧地配置CLB来令实在现工程师想要实现的逻辑功能。

FPGA的并行处理能力也很强大,其可编程性也适用于不断优化的深度学习算法的运算。目前很多公司基于FPGA开拓人工智能处理器。于2016年景立的深鉴科技,就在研发深度学习通用办理方案。2016年初,深鉴科技就设计了基于FPGA、针对深度学习的DPU硬件架构。该产品实现了高性能功耗比,并且本钱也比GPU产品低很多。今年8月加州的Hot Chips大会上,百度也发布了其基于FPGA芯片的A.I加速芯片—XPU。该芯片有256核,旨在寻求性能和效率的平衡,处理多样化打算任务。

基于FPGA开拓的人工智能处理用具有高性能、低能耗、可硬件编程的特点。

1)高性能

除了GPU,FPGA也善于并行打算,基于FPGA开拓的处理器可以实现更高的并行打算。而且FPGA带有丰富的片上存储资源,可以大大减少访问片外存储的延迟,提高打算性能,访问DRAM储存大约是访问寄存器存储延迟的几百倍以上。

2)低能耗

比较于CPU和GPU,FPGA的能耗上风紧张有两个缘故原由:1)比较于CPU、GPU,FPGA架构有一定的优化,CPU、GPU须要频繁的访问DRAM,而这个能量花费较大,FPGA可以减少这方面的能耗。2)FPGA的主频低,CPU和GPU的主频一样平常在1-3GHz之间,而FPGA的主频一样平常在500MHz一下。因此,FPGA的能耗要低于CPU、GPU。

3)可硬件编程

FPGA可硬件编程,并且可以进行静态重复编程和动态系统重配置。用户可像编程修正软件一样修正系统的硬件功能,大大增强了系统设计的灵巧性和通用性。使得FPGA可以灵巧地支配在须要修正硬件设置场景中。

FPGA+CPU异构架构被越来越多地研究和认可。比较于CPU+GPU,由于FPGA的高性能低功耗等上风使FPGA+CPU可以供应更好的单位功耗性能,且更易于修正和编程。因此FPGA适宜做可并行打算的任务,如矩阵运算。如果是一些判断类的问题,FPGA算得并没有CPU快。以是已经有研究职员磋商FPGA+CPU的架构模式。

5.3 全定制芯片—ASIC

ASIC(Application Specific IntegratedCircuit)在集成电路界被认为是一种为专门目的而设计的集成电路。是指应特定用户哀求和特定电子系统的须要而设计、制造的集成电路。ASIC的特点是面向特定用户的需求,ASIC在批量生产时与通用集成电路比较具有体积更小、功耗更低、可靠性提高、性能提高、保密性增强、本钱降落等优点。大略地讲,ASIC芯片便是通过台积电等代工厂流片的芯片。目前,基于ASIC的人工智能芯片有地平线BPU、谷歌的TPU。

基于ASIC开拓人工智能芯片开拓周期较长。基于ASIC开拓人工智能芯片更像是电路设计,须要反复优化,须要经历较长的流片周期,故开拓周期较长。

量产后ASIC人工智能芯片本钱及价格较低。虽然相较于FPGA, ASIC人工智能芯片须要经历较长的开拓周期,并且须要价格昂贵的流片投入,但是这些前期开拓投入在量产后会被摊薄,以是量产后,ASIC人工智能芯片的本钱和价格会低于FPGA人工智能芯片。

ASIC芯片性能功耗比较高。从性能功耗最近看,ASIC作为定制芯片,其性能要比基于通用芯片FPGA开拓出的各种半定制人工智能芯片更具有上风。而且ASIC也并不是完备不具备可配置能力,只是没有FPGA那么灵巧,只要在设计的时候把电路做成某些参数可调即可。

ASIC人工智能芯片紧张面向消费电子市场。ASIC更高的性能,更低的量产本钱以及有限可配置特性,使其紧张面向消费电子市场,如寒武纪等公司。

5.4 类脑芯片

类人脑芯片架构是一款基于神经形态的工程,旨在冲破“冯·诺依曼”架构的束缚,仿照人脑处理过程,感知天下、处理问题。这种芯片的功能类似于大脑的神经突触,处理器类似于神经元,而其通讯系统类似于神经纤维,可以许可开拓者为类人脑芯片设计运用程序。通过这种神经元网络系统,打算机可以感知、影象和处理大量不同的信息。类脑芯片的两大打破:1、有望形成自主认知的新形式;2、打破传统打算机体系构造的限定,实现数据并行传送、分布式处理,能以极低功耗实时处理大量数据。

06.总结

CPU 有强大的调度、管理、折衷能力。运用范围广。开拓方便且灵巧。但其在大量数据处理上没有 GPU 专业,相对运算量低,但功耗不低。

GPU:是单指令、多数据处理,采取数量浩瀚的打算单元和超长的流水线,如名字一样,图形处理器,GPU长于处理图像领域的运算加速。但GPU无法单独事情,必须由CPU进行掌握调用才能事情。CPU可单独浸染,处理繁芜的逻辑运算和不同的数据类型,但当须要大量的处理类型统一的数据时,则可调用GPU进行并行打算。

FPGA:和GPU相反,FPGA适用于多指令,单数据流的剖析,因此常用于预测阶段,如云端。FPGA是用硬件实现软件算法,因此在实现繁芜算法方面有一定的难度,缺陷是价格比较高。将FPGA和GPU比拟创造,一是短缺内存和掌握所带来的存储和读取部分,速率更快。二是由于短缺读取的浸染,以是功耗低,劣势是运算量并不是很大。结合CPU和GPU各自的上风,有一种办理方案便是异构。

ASIC芯片:是专用定制芯片,为实现特定哀求而定制的芯片。除了不能扩展以外,在功耗、可靠性、体积方面都有上风,尤其在高性能、低功耗的移动端。谷歌的TPU、寒武纪的MLU,地平线的BPU都属于ASIC芯片。谷歌的TPU比CPU和GPU的方案快30-80倍,与CPU和GPU比较,TPU把掌握缩小了,因此减少了芯片的面积,降落了功耗。

四种架构将走向哪里?

众所周知,通用途理器(CPU)的摩尔定律已入晚年,而机器学习和Web 做事的规模却在指数级增长。

人们利用定制硬件来加速常见的打算任务,然而日月牙异的行业又哀求这些定制的硬件可被重新编程来实行新类型的打算任务。

将以上四种架构比拟,GPU未来的主攻方向是高等繁芜算法和通用性人工智能平台,其发展路线分两条走:一是主攻高端算法的实现,对付指令的逻辑性掌握要更繁芜一些,在面向需求通用的AI打算方面具有上风;二是主攻通用性人工智能平台,GPU的通用性强,以是运用于大型人工智能平台可高效完身分歧的需求。FPGA更适用于各种细分的行业,人工智能会运用到各个细分领域。

ASIC芯片是全定制芯片,长远看适用于人工智能。现在很多做AI算法的企业也是从这个点切入。由于算法繁芜度越强,越须要一套专用的芯片架构与其进行对应,ASIC基于人工智能算法进行定制,其发展前景看好。类脑芯片是人工智能终极的发展模式,但是离家当化还很迢遥。

几个品牌的SOC及域掌握器做的还是不错的,尤其是基于NVIDIA Xavier以及前期PX2等芯片的开拓。海内大部分企业的运用比较集中在Xavier平台和Linux系统,尤其是新势力造车企业,而传统车企更青睐TI、瑞萨等半导体公司的智能AI芯片以及QNX系统。海内基于Xavier做开拓的企业很多,天津优控智行目前的域掌握器产品在行业内属于中等偏上水平,但是其软件工具和做事做得相对有些上风,后期有韶光也扒一扒地平线、智行者等企业的域掌握器学习学习。