论文指出当前方法存在特色信息丢失或退化的问题,影响了非相邻水平的领悟效果,提出了一种支持非相邻层次直接交互的渐近特色金字塔网络(AFPN)避免非相邻层之间较大的语义差距

论文题目:

AFPN: Asymptotic Feature Pyramid Network for Object Detection

择要

在目标检测任务中,多尺度特色对具有尺度差异的目标进行编码具有主要意义。多尺度特色提取的常用策略是采取经典的自顶向下和自底向上的特色金字塔网络。然而,这些方法存在特色信息丢失或退化的问题,影响了非相邻水平的领悟效果。提出了一种支持非相邻层次直接交互的渐近特色金字塔网络(AFPN)。AFPN首先领悟两个相邻的低级特色,然后逐渐将高等特色融入领悟过程,这样可以避免非相邻层之间较大的语义差距。考虑到在每个空间位置的特色领悟过程中可能涌现多目标信息冲突,进一步利用自适应空间领悟操作来缓解这些不一致。我们将提出的AFPN纳入两阶段和一阶段目标检测框架,并利用MS-COCO 2017验证和测试数据集进行评估。实验评估表明,我们的方法比其他最前辈的特色金字塔网络得到了更有竞争力的结果。

代码:https://github.com/gyyang23/AFPN

1先容

目标检测是打算机视觉中的一个基本问题,旨在检测和定位图像或视频中的目标。随着深度学习的涌现,目标检测已经发生了范式转变,基于深度学习的方法已经成为主流方法。正在进行的研究导致了许多新方法的发展,表明了该领域进一步发展的潜力。

基于深度学习的目标检测方法常日分为单阶段方法和两阶段方法,单阶段方法直接从输入图像中预测物体的种别和位置。而Twostage方法则是师长西席成一组候选区域,然后对这些区域进行分类和位置回归。在单一尺度的特色提取中,图像中物体大小的不愿定性会导致细节信息的丢失。因此,目标检测模型常日引入特色金字塔架构来办理尺度变革问题。个中,FPN是最常用的特色金字塔架构,利用FPN,单级和两级检测器都能得到更好的检测效果。在FPN的根本上,PAFPN在特色金字塔网络中增加了一条自下而上的路径,填补了FPN的高层特色中缺少底层特色细节的不敷。

对付目标检测任务,真正有用的特色必须包含关于目标的详细和语义信息,并且这些特色该当由足够深度的神经网络提取。在现有的特色金字塔架构中,金字塔顶真个高等特色须要经由多个中间尺度的传播,并与这些中间尺度上的特色相互浸染,才能与底层的低级特色领悟。

在这种传播和交互的过程中,高层特色的语义信息可能会丢失或降级。同时,自底向上的PAFPN路径带来了相反的问题:底层特色的详细信息可能在传播和交互过程中丢失或退化。在最近的研究中,GraphFPN办理了仅相邻尺度特色之间直接交互的局限性,并引入了图神经网络来办理这一问题。然而,额外的图神经网络构造显著增加了检测模型的参数和打算量,这超过了它的好处。

现有的特色金字塔网络常日是将骨干网络天生的高等特色上采样到低级特色上。然而,我们把稳到HRNet在全体特色提取过程中都保持了低级特色,并反复领悟低级和高等特色以天生更丰富的低级特色。该方法在人体姿态估计领域具有突出的上风。受HRNet网络架构的启示,我们提出了一个渐近特色金字塔网络(AFPN)来办理上述限定。在主干自底向上的特色提取过程中,我们在第一阶段通过结合两个不同分辨率的低级特色来启动领悟过程。随着我们进入后期阶段,我们逐渐将高等特色纳入领悟过程,终极领悟主干的顶级特色,这种领悟办法可以避免非相邻层之间存在较大的语义差距。

在此过程中,低级特色与高等特色的语义信息领悟,高等特色与低级特色的细节信息领悟。由于它们之间的直接相互浸染,避免了多级传输过程中信息的丢失或退化。在全体特色领悟过程中,由于层次之间的某一位置可能存在不同工具的抵牾,元素求和并不是一种有效的方法。为理解决这一问题,我们利用自适应空间领悟运算对多层次领悟过程中的特色进行过滤。这使我们能够保留有用的信息进行领悟。

为了评估我们的方法的性能,我们在MS COCO 2017数据集上利用了Faster R-CNN框架。详细来说,我们利用ResNet-50和ResNet-101作为主干网,与基于fpn的Faster R-CNN比较,它们分别提高了1.6%和2.6%。我们将其与其他特色金字塔网络进行比较。实验结果表明,所提出的AFPN不仅比其他最前辈的特色金字塔网络具有更强的竞争力,而且具有最低的每秒浮点运算(FLOPs)。此外,我们将AFPN扩展到一级检测器。我们在YOLOv5框架上实现了我们提出的方法,在参数较少的情形下得到了优于基线的性能。

我们的紧张贡献如下:

(1)我们引入了一个渐近特色金字塔网络(AFPN),它促进了非相邻层之间的直接特色领悟,从而防止了特色信息在传输和交互过程中的丢失或退化。(2)为抑制不同层次特色之间的信息抵牾,在多层次特色领悟过程中引入自适应空间领悟操作。

(3)在MS COCO 2017验证和测试数据集上的大量实验表明,与其他特色金字塔网络比较,我们的方法具有更高的打算效率,同时得到更有竞争力的结果。

2干系事情

传统的打算机视觉方法常日只从图像中提取一个尺度特色进行剖析和处理,这将导致对不同大小的物体或不同比例的场景的检测性能较差。研究职员已经构建了包含不同尺度特色的特色金字塔,战胜了利用单一尺度特色的局限性。此外,许多研究提出了特色领悟模块,旨在增强或改进特色金字塔网络,进一步提高检测器的性能。

a .特色金字塔

FPN采取自顶向下的办法将高层特色转移到低层特色,实现不同层次特色的领悟。然而,在这个过程中,高等特性不会与低级特性领悟。为此,PAFPN在FPN的根本上增加了一条自底向上的路径,使高层特色在低层特色中获取细节。与固定网络构造方法不同,NASFPN利用神经构造搜索算法自动搜索最优连接构造。最近,其他领域的思想也被引入到特色金字塔建筑中。例如,FPT引入了NLP领域的自把稳机制,提取不同层次的特色,并利用多尺度把稳网络对这些特色进行聚合。GraphFPN利用图神经网络在特色金字塔上进行交互和信息传播。虽然GraphFPN也促进了非相邻层之间的直接交互,但它对图神经网络的依赖大大增加了参数数量和打算繁芜度,FPT也存在类似的问题。比较之下,AFPN只引入正常的卷积分量。因此,我们的AFPN在实际运用中更具可行性和实用性。

B.特色领悟模块

特色领悟模块常日被合并到一个预先存在的固定拓扑特色金字塔中,以增强其特色,也进行了一些研究来增强特色金字塔的上采样模块。本文将不改变特色金字塔拓扑构造的模块称为特色领悟模块。

CARAFE是一种通用的、轻量级的、高效的上采样算子,可以聚合大的感想熏染场信息。考虑到不同层次的特色之间可能存在相互抵牾的信息,ASFF为不同层次的特色增加了权重,以便有效地领悟它们。DRFPN通过合并空间细化块(SRB)和通道细化块(CRB)扩展了PAFPN架构。SRB模块利用相邻级别的高下文信息来学习上采样点的位置和内容,而CRB模块利用把稳机制来学习自适应信道合并策略。与这些特色金字塔体系构造比较,特色金字塔模块可以无缝集成到各种现有的特色金字塔体系构造中,为办理特色金字塔的各种局限性供应了一个实用的办理方案。特色金字塔的一个局限性是在特色领悟过程中,同一位置不同目标的信息会共存。这种限定在AFPN中尤为明显,由于它须要更多的特色领悟。此外,我们还进行了自适应空间领悟,以有效地领悟不同层次的特色。

3渐近特色金字塔网络

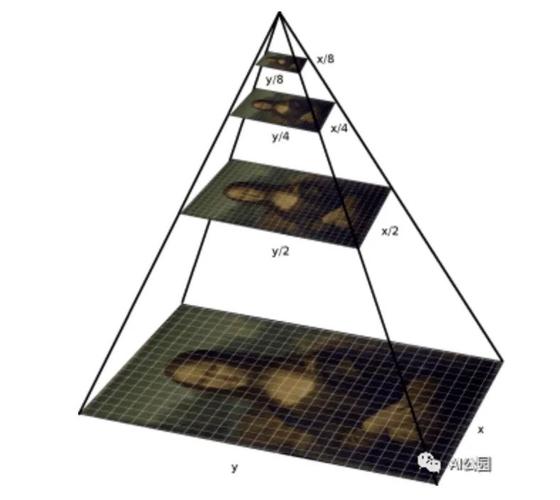

A.提取多层次特色

与许多基于特色金字塔网络的目标检测方法一样,在特色领悟之前从主干提取不同层次的特色。我们遵照Faster R-CNN框架的设计,从主干的每个特色层中提取末了一层特色,得到一组不同尺度的特色,表示为{C2, C3, C4, C5}。为了进行特色领悟,首先将底层特色C2和C3输入到特色金字塔网络中,然后加入C4,末了加入C5。

经由特色领悟步骤,得到一组多尺度特色{P2, P3, P4, P5}。在Faster R-CNN框架上进行的实验中,我们对P5进行了一次步长为2的卷积,然后对P6进行了一次步长为1的卷积,从而担保了输出的同等性。终极的多尺度特色集为{P2, P3, P4, P5, P6},对应的特色步长为{4,8,16,32,64}像素。须要把稳的是,YOLO只将{C3, C4, C5}输入到特色金字塔网络中,其输出为{P3, P4, P5}。

B.渐近构造

所提出的AFPN的构造如图2所示。在骨干网自底向上的特色提取过程中,AFPN逐步领悟底层、高层和顶层特色。详细来说,AFPN首先领悟底层特色,然后是深层特色,末了领悟最顶层特色,也便是最抽象的特色。非相邻层次特色之间的语义差距大于相邻层次特色之间的语义差距,尤其是底部和顶部特色之间的语义差距。这直接导致了非相邻层次特色的领悟效果不佳。因此,直策应用C2、C3、C4、C5进行特色领悟是不合理的。由于AFPN的架构是渐近的,这将使不同层次特色的语义信息在渐近领悟的过程中更加靠近,从而缓解上述问题。例如,C2和C3之间的特色领悟减少了它们之间的语义差距。由于C3和C4是相邻的层次特色,因此减小了C2和C4之间的语义差距。

为了对齐维度并为特色领悟做准备,我们利用1 × 1卷积和双线性插值方法对特色进行上采样。另一方面,我们根据所需的下采样率利用不同的卷积核和步进实行下采样。例如,我们运用步幅为2的2 × 2卷积来实现2次下采样,运用步幅为4的4 × 4卷积来实现4次下采样,以及运用步幅为8的8 × 8卷积来实现8次下采样。在特色领悟之后,我们连续利用四个残差单元学习特色,类似于ResNet。每个残差单元由两个3 × 3的卷积组成。由于在YOLO中只利用三个级别的特色,没有8次上采样和8次下采样。

C.自适应空间领悟

我们利用ASFF在多层次特色领悟过程中为不同层次的特色分配不同的空间权重,增强关键层次的主要性,减轻来自不同工具的抵牾信息的影响。如图3所示,我们领悟了三个层次的特色。设xn→lij表示从n层到l层(i, j)处的特色向量,通过多层次特色自适应空间领悟得到的特色向量,记为ylij,由特色向量x1→lij、x2→lij、x3→lij的线性组合定义为:

个中,αlij、βlij、γlij表示第1层上三个层次特色的空间权重,且αlij + βlij + γlij = 1为约束条件。考虑到AFPN各阶段领悟特色数量的差异,我们实现了阶段特天命量的自适应空间领悟模块。

4实验

A.实验设置

数据集:我们在MS COCO 2017数据集、118k演习图像(train2017)、5k验证图像(val2017)和20k测试图像(testdev)上评估了所提出的方法。由于测试开拓标签的不可用性,我们将模型天生的边界框上传到指定的评估网站,以得到性能指标。详细而言,我们选择均匀精度(AP)、AP50、AP75、APS、APM和APL作为评估指标。

实现细节:我们利用MMDetection作为底层框架,在2块NVidia RTX3090 gpu上进行实验。在演习过程中,我们采取SGD作为优化器,并将学习率、权重衰减和动量分别配置为0.01、0.0001和0.9。每个小批包含8个图像,分布在2个gpu上。为了公正比较,我们在不同的实验中利用了不同分辨率的图像作为输入,我们将在每个比较实验部分描述详细情形。别的的超参数遵照MMDetection的默认配置。

B.不同特色金字塔网络的比较

在本节中,用“”表示的方法和我们提出的方法进行了36个epoch的演习。在第27和33个期间,学习率分别降落了10倍。在数据增强过程中采取了随机翻转和随机裁剪。我们将我们的方法与最近的特色金字塔网络的性能进行了比较。考虑到模型的性能严重依赖于输入图像的大小,我们对我们提出的方法和最近利用相似分辨率的输入图像的特色金字塔网络进行了比较剖析。

如表1所示,当输入图像尺寸为640 × 640时,我们的方法得到了较强的性能,AP为39.0%,乃至超过了一些更大分辨率的模型。与FPN和PAFPN比较,我们的AFPN AP较val2017分别提高了1.6%和0.9%,而在大多数其他指标上都超过了他们。值得把稳的是,由于NASFPN是在RetinaNet框架上搜索的,它在Faster R-CNN框架上的表现并不是特殊令人印象深刻。比较之下,我们的AFPN在AP中比NASFPN赶过1.3%。当输入图像尺寸为800 × 1000时,我们的AFPN实现了41.0%的AP,超过了其他方法的性能。在构建AFPN架构时,我们没有考虑上采样的质量。

为理解决这一毛病,我们用CAFAFE算子取代了双线性插值算子,它具有更好的上采样质量。在进一步的实验中,我们创造这种更换导致了我们模型性能的显著提高。此外,我们用ResNet-101代替主干,在MS COCO test-dev上进行测试。表2显示,与基线(FPN)比较,我们的AFPN的AP增加了2.6%。与同类技能比较,我们的方法也取得了具有竞争力的结果,同时在AP、APS、APM和APL方面保持领先地位。

C.不同探测器的结果

为了证明我们方法的通用性,我们将AFPN合并到两级和一级检测器中。实验结果表明,我们的方法显著提高了两种检测器框架的性能。

两级检测器:两级检测器的实验结果见表三,表中所有方法的输入图像大小为800 × 1333。在数据增强过程中只利用随机翻转。在我们的研究中,我们评估了Faster R-CNN和Dynamic R-CNN。我们的实验结果表明,在相同的演习韶光下,用AFPN代替检测器的FPN可以显著提高检测性能,特殊是对付大型物体的检测。这是由于FPN的体系构造不许可高等特色得到低级特色的详细信息。我们的AFPN并没有提高检测器检测小目标的能力,这一点得到了APS结果的支持。此外,我们还创造AFPN在AP50中低于FPN,而在AP75中优于FPN。因此,相对付FPN,我们的AFPN更适宜高精度定位场景。

一级检测器:在YOLOv5上的实验结果如表4所示,检测器利用640 × 640尺寸的输入图像进行300次演习。我们的实验结果表明,与YOLOv5的原始颈部(YOLOv5PAFPN)比较,我们的AFPN在检测性能上有了显著提高,特殊是在检测大型物体时。详细来说,对付YOLOv5-n,我们的AFPN将大物体(APL)的均匀精度提高了3.4%,对付YOLOv5-s,它将APL提高了2.6%。此外,我们的AFPN在AP, APS, APM和APL方面保持领先地位。

D.可学习参数和打算本钱

网络的深度和宽度都会影响网络的表示能力,由于AFPN的深度已经增强了模型的表示能力,我们采取减小网络宽度的策略来优化模型。详细来说,在两阶段检测器中,我们将进入特色金字塔网络的特色维数降到了原来的1/8。在一级检测器中,我们将尺寸减小到原来的1/4。表1给出了各种特色金字塔网络(包括我们提出的AFPN)的可学习参数数量和总打算本钱。根据表中给出的结果,我们的AFPN架构有5020万个可学习的参数,在640 × 640的分辨率下,GFLOPs达到90.0。与FPN比较,我们的AFPN中的参数数量增加了21.0%。然而,我们在表中的所有方法中实现了最低的GFLOPs。造成这种征象的紧张缘故原由是我们降落了特色维数。表4的实验结果表明,AFPN在YOLOv5上利用更少的参数实现了更高的性能。

E.溶解研究

为了研究自适应空间领悟操作在我们的AFPN中的效果,我们将其更换为其余两种领悟操作,即元素总和和元素串联,用于溶解研究。我们的实验利用了以ResNet-50为骨干的Faster R-CNN框架。如溶解研究的表5所示,我们不雅观察到元素连接手术可以达到与自适应空间领悟手术相称的性能水平。然而,AP、AP50、AP75、APM和APL指标略低。考虑到自适应空间领悟对元素明智和进行加权运算以抑制特色之间的抵牾,可以合理地假设自适应空间领悟的性能优于元素明智和。实验结果也证明了这一点。

5结论

在本文中,我们提出渐近特色金字塔网络(AFPN)来办理非相邻层之间的间接交互导致的信息丢失和退化问题。我们的AFPN采取渐近办法进行特色领悟和自适应空间领悟运算,在领悟过程中提取更多有用的信息。大量的实验结果表明,与各种检测框架的基线方法比较,AFPN具有优胜的性能,在未来,我们将探索更轻的AFPN及其在其他视觉任务中的适用性。